苹果每个应用,将被AI重构

一直以来,苹果在大模型、语音助手上的研究不断推陈出新,或许我们能够从中获得iOS 18所具备AI能力的关键一瞥。「Siri太笨,根本无法与ChatGPT竞争」,前苹果工程师John Burkey曾对Siri的评价如此不堪。 不过,诞生于11年的Siri,终于要迎来翻身的机会。

更小、更高效LLM装进iPhone

相信所有人的期望都是一样的——想要一个更好的Siri。 而现在看起来,换新的Siri即将到来,完成超强进化!

论文地址:https://arxiv.org/pdf/2312.11514

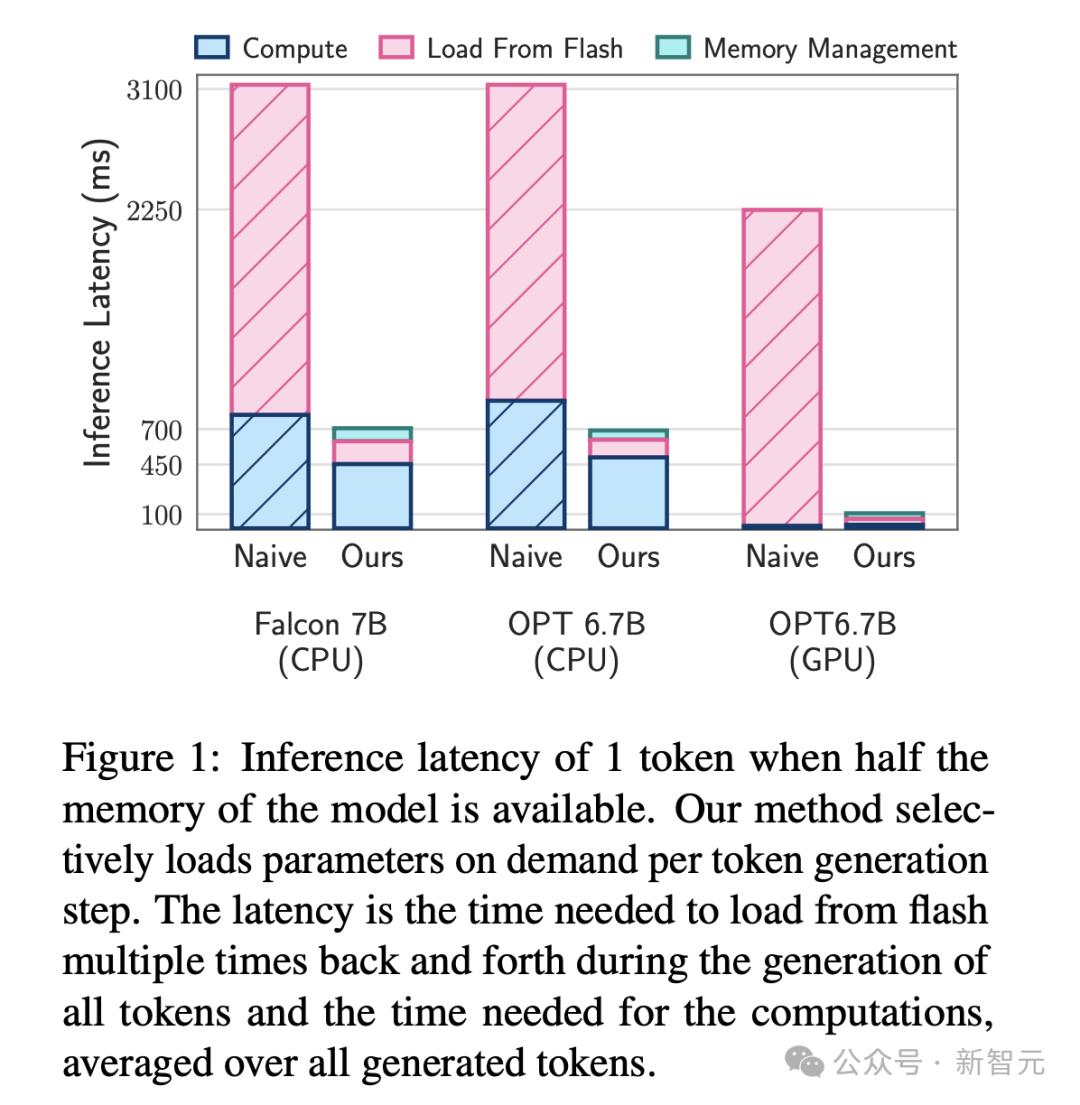

具体来说,研究证明了,在SSD上运行的LLM的大小,可以达到可用DRAM的2倍。 与传统的CPU加载方法相比,推理速度提高了4-5倍,而GPU提高了20-25倍。 他们发现 ,通过利用设备上最廉价的可用存储模型,模型可以运行得更快、更高效。

论文地址:https://arxiv.org/pdf/2310.20144

总而言之,苹果正努力解决模型领域的一个核心矛盾:模型越大越好用,但在终端上耗电快运行慢。 与其他科技公司一样,苹果正在这一点上找到平衡。Siri完成超进化!

苹果研究AI终归解决一个至关重要的问题,如何让Siri变得更加出色。 在内部,苹果团队设想开发一种,无需唤醒词Hey Siri或Siri,就能使用AI助手的方法。 没有声音提示,那该如何让设备通过「直觉」判断一个人在讲话? 这一难题,比语音触发检测更具挑战性。

论文地址:https://arxiv.org/pdf/2403.14438

这也许就是,为什么另一组研究人员,开发出了一个系统可以更准确地检测唤醒词。

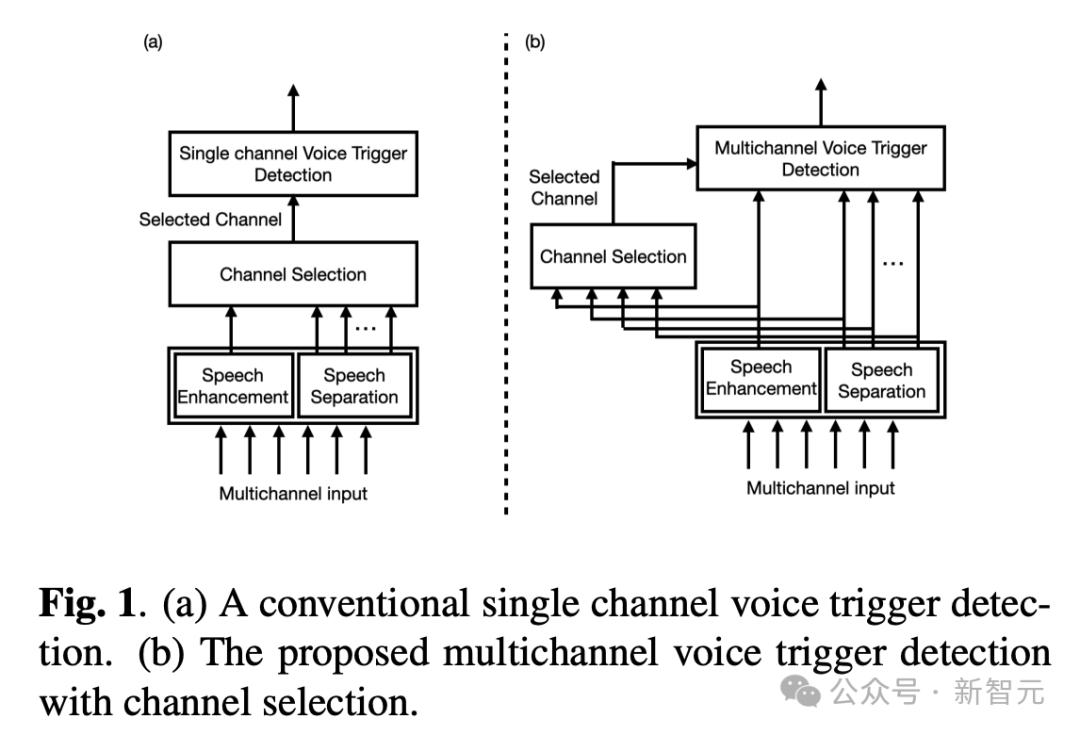

论文地址:https://arxiv.org/pdf/2309.16036

具体来说,作者提出了语音触发(VT)的多通道声学模型,将前端的多通道输出直接输入VT模型。 他们采用了TAC(Transform-Average-Conatenate)模块,并通过合并来自传统通道选择的通道,对TAC模块进行了修改,让模型能够在存在多个说话人的情况下关注目标说话人。

论文地址:https://arxiv.org/pdf/2310.07062

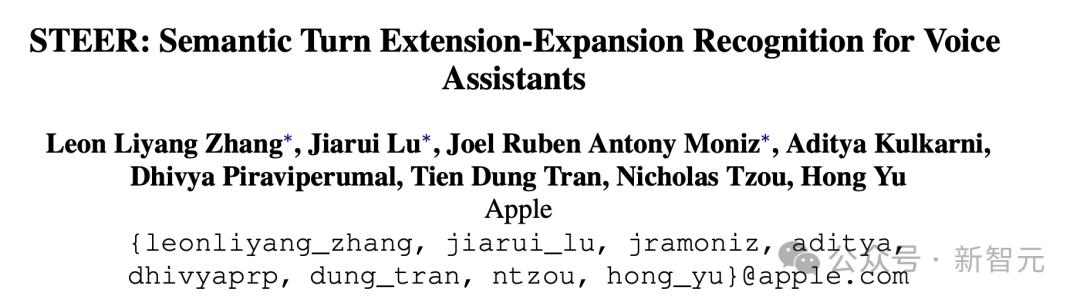

在这两种情况中,LLM的魅力在于,理论上它可以更快地处理更多信息。 例如,在关于唤醒词的研究中,研究人员发现,如果不试图摒弃所有不必要的声音,而是把所有声音都输入模型,让它来处理哪些是重要的,哪些是不重要的,那么唤醒词的效果就会可靠得多。 一旦Siri听到你的声音,苹果就会做很多工作,以确保它能更好地理解和沟通。 在另一篇论文中,苹果还开发了一个名为STEER系统,旨在改善用户与助手之间的交流。

论文地址:https://arxiv.org/pdf/2310.16990

在另一个例子中,它使用LLM来更好地理解「模棱两可的问题」,无论你怎么说,它都能弄清楚你的意思。 在不确定的情况下,智能对话智能体可能需要主动提出好的问题,从而更有效地解决问题,从而减少不确定性。

苹果每个应用,将被AI重构

除了关注原始的技术发展,苹果也非常关注人工智能的日常应用。 对于苹果来说,一个重点领域就是健康: LLM可以帮助分析处理各种设备收集到的大量生物识别数据,并帮助理解这些数据。 苹果可以通过研究收集和整理你的所有运动数据,利用步态识别和耳机来识别你的身份,以及如何跟踪和理解你的心率数据,来监测你的身体状况,为你提供合适的安全建议。

论文地址:https://arxiv.org/pdf/2402.06071

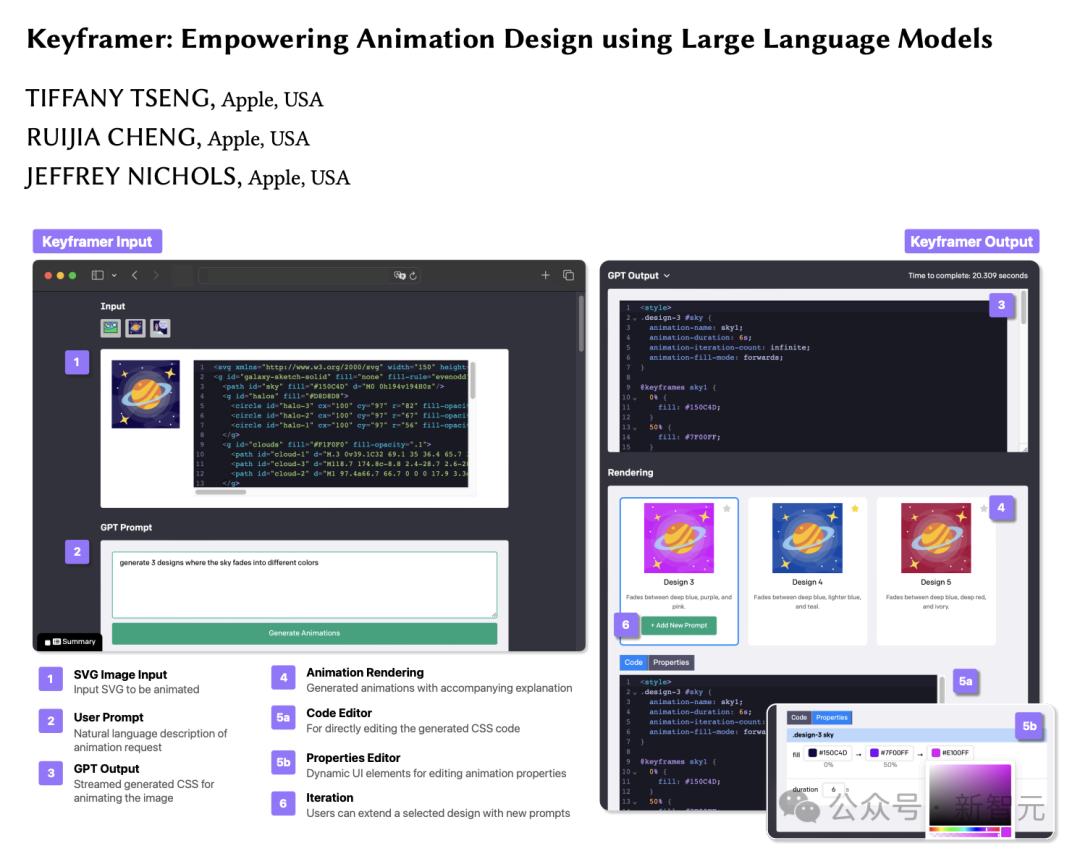

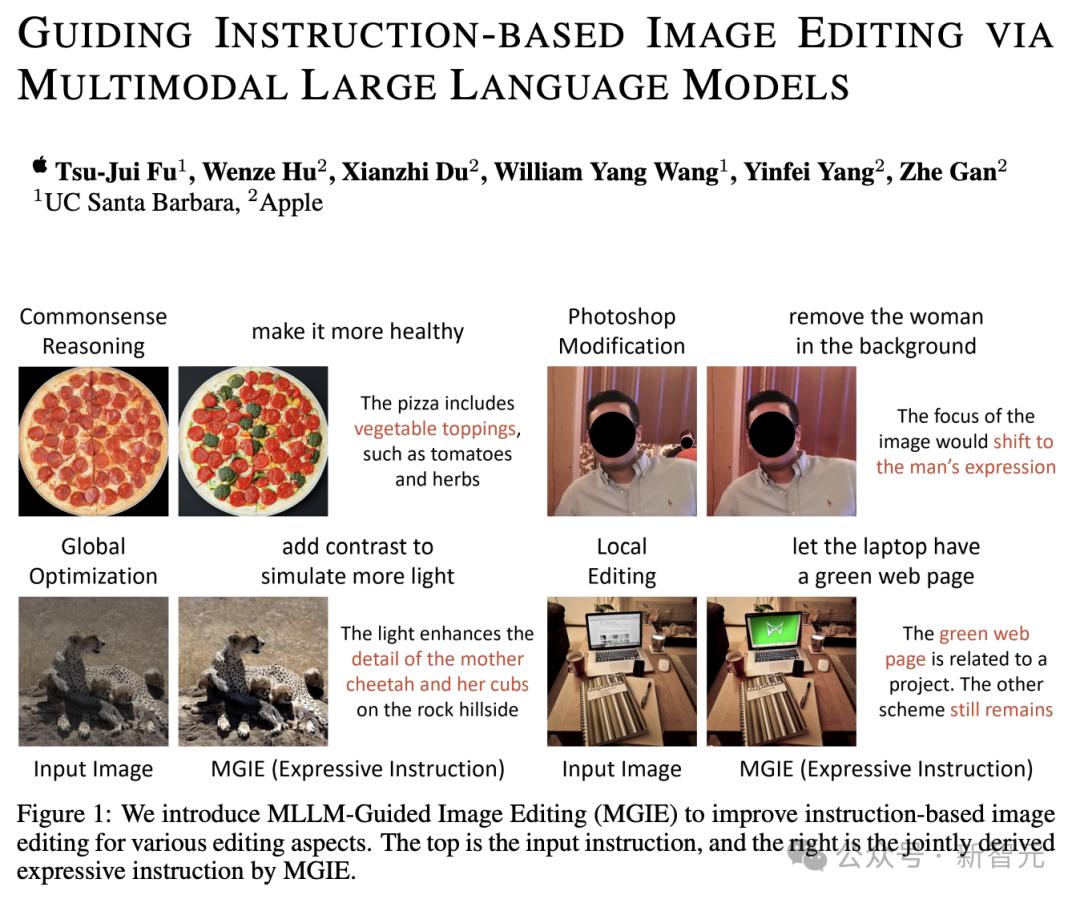

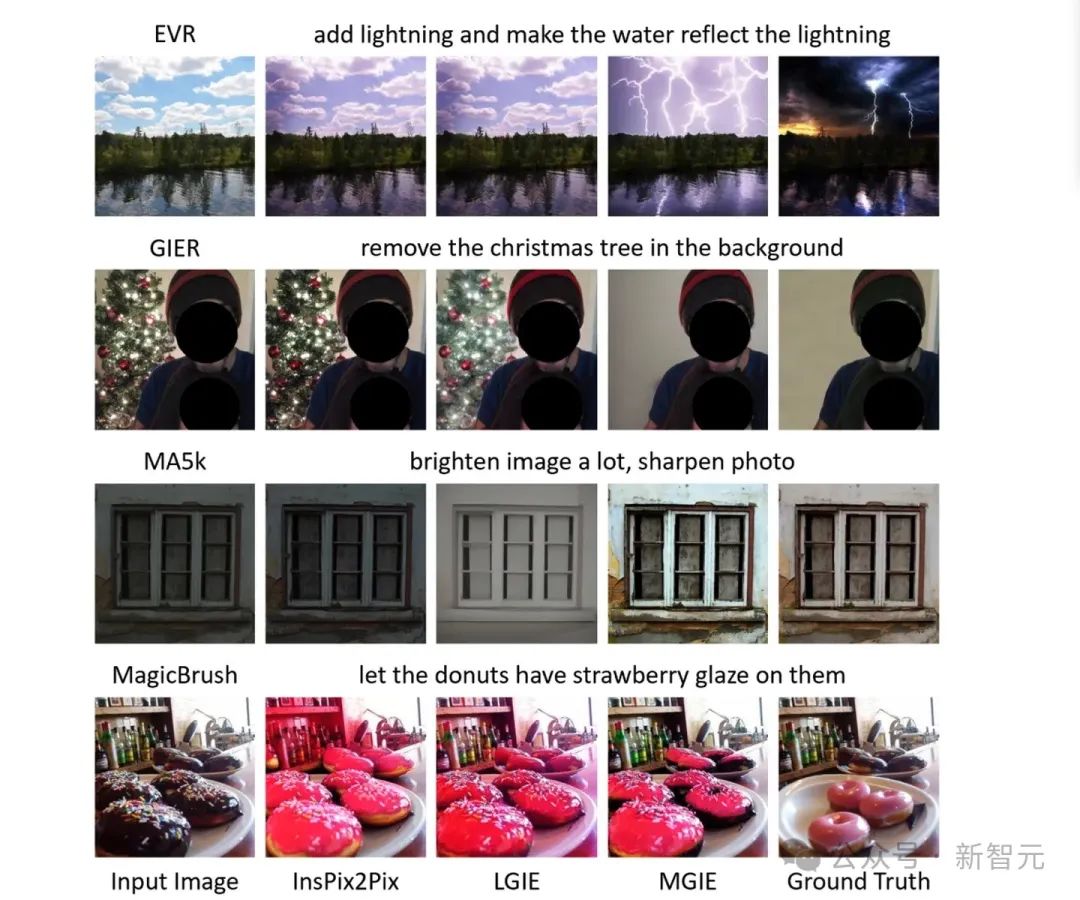

此外,苹果还有开发了一款名为MGIE的工具,可以让你通过描述内容来编辑图片(比如「让天空更蓝」、「让我的脸不那么怪异」、「添加一些石头」等等)。

论文地址:https://arxiv.org/pdf/2309.17102

论文中,研究人员表示,MGIE不需要简短但含糊的提示,便可以明确地推导出视觉感知的意图,从而实现合理的图像编辑。 「最初的实验并不完美,但令人印象深刻」。

论文地址:https://arxiv.org/pdf/2401.12068

比如,像在TikTok或Instagram上那样混音歌曲,这个AI可能会派上用场。

论文地址:https://arxiv.org/pdf/2404.05719

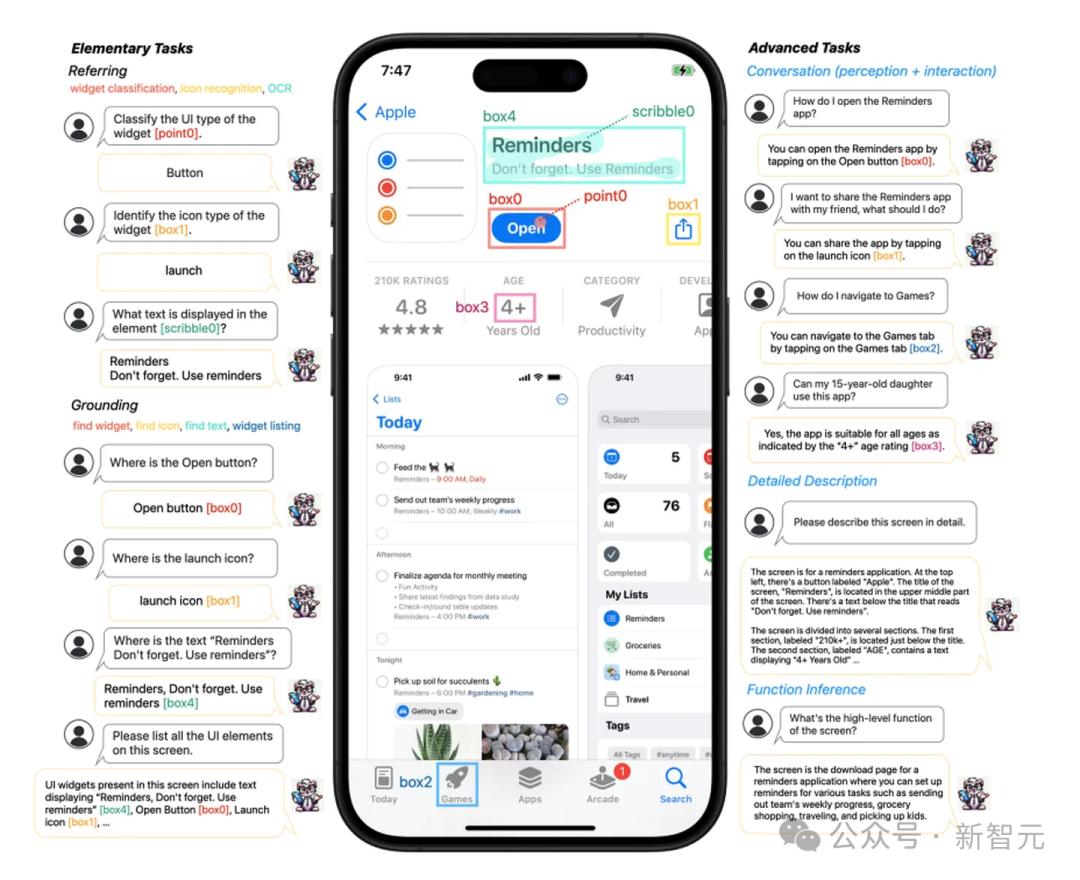

甚至,Ferret还可以帮助你导航应用程序、回答有关App Store评级的问题、描述你正在看的内容等等。 一旦这种技术得以应用,可能彻底改变每个人使用手机的方式,以及Vision Pro和智能眼镜的使用方式。